Tại sự kiện dành cho lập trình viên hôm 18/3, Nvidia công bố loạt sản phẩm mới nhằm củng cố vị thế trên thị trường trí tuệ nhân tạo (AI). Giá cổ phiếu của hãng chip này đã tăng gấp 54 lần và doanh thu tăng hơn ba lần từ khi ChatGPT khởi động cuộc đua AI trên toàn cầu cuối năm 2022. GPU máy chủ cao cấp của Nvidia đóng vai trò quan trọng để đào tạo và triển khai mô hình ngôn ngữ lớn. Các công ty như Microsoft và Meta đã chi hàng tỷ USD để mua chip.

Nvidia đặt tên thế hệ chip AI mới là Blackwell. Con chip Blackwell đầu tiên – GB200 – sẽ được bán ra từ cuối năm nay. Nvidia đang cung cấp cho khách hàng nhiều chip mạnh hơn để thúc đẩy các đơn hàng mới. Hiện tại, các khách hàng vẫn đang tranh giành để có được chip H100 Hopper.

“Hopper tuyệt vời nhưng chúng ta cần GPU lớn hơn”, CEO Nvidia Jensen Huang phát biểu tại sự kiện.

Bên cạnh chip Blackwell, Nvidia cũng giới thiệu phần mềm NIM giúp triển khai AI dễ dàng hơn. Theo các quan chức Nvidia, công ty đang dần trở thành một nhà cung cấp nền tảng như Apple và Microsoft hơn là nhà cung ứng chip.

“Blackwell không phải một con chip, đó là tên của một nền tảng”, ông Huang nói. Phó Chủ tịch Nvidia Manuvir Das hứa hẹn phần mềm NIM giúp lập trình viên chạy các chương trình trên mọi GPU Nvidia, dù cũ hay mới, để tiếp cận nhiều người hơn.

Blackwell, “truyền nhân” của Hopper

Mỗi hai năm, Nvidia lại cập nhật kiến trúc GPU một lần, mở khóa tăng trưởng hiệu suất mới. Nhiều mô hình AI ra mắt năm qua được đào tạo trên kiến trúc Hopper xuất hiện từ năm 2022.

Nvidia cho biết các chip dựa trên Blackwell như GB200 nâng cấp hiệu suất AI đáng kể cho các doanh nghiệp AI, 20 petaflops so với 4 petaflops trên H100. Năng lực xử lý này cho phép các doanh nghiệp AI đào tạo mô hình lớn hơn và phức tạp hơn.

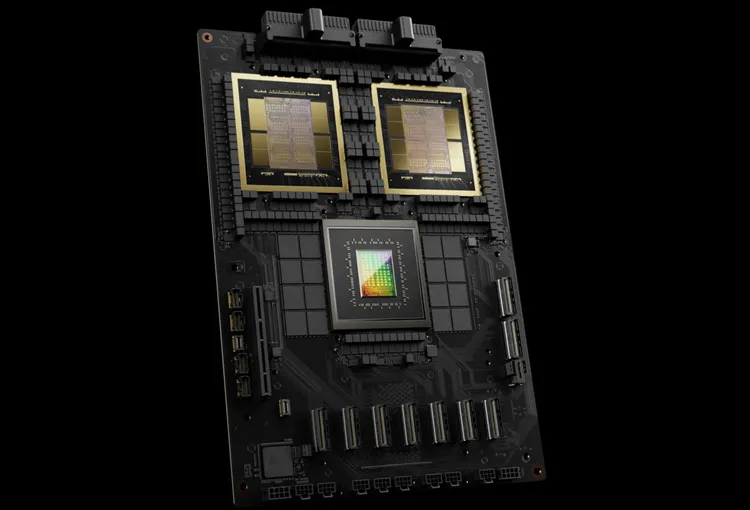

GPU Blackwell lớn và kết hợp hai khuôn được sản xuất riêng biệt thành một chip. Nó cũng có sẵn dưới đạng máy chủ hoàn chỉnh có tên GB200 NVLink 2, kết hợp 72 GPU Blackwell và các bộ phận khác của Nvidia được thiết kế để đào tạo các mô hình AI.

Amazon, Google, Microsoft và Oracle sẽ bán quyền truy cập GB200 thông qua dịch vụ đám mây. GB200 kết hợp 2 GPU B200 Blackwell với một CPU Grace. Nvidia cho biết Amazon Web Services (AWS) sẽ xây dựng một cụm máy chủ với 20.000 chip GB200.

Hệ thống có thể triển khai mô hình 27 nghìn tỷ tham số, lớn hơn nhiều so với các mô hình lớn nhất hiện nay như GPT-4 (1,7 nghìn tỷ tham số). Nhiều nhà nghiên cứu AI tin rằng các mô hình lớn hơn với nhiều tham số và dữ liệu hơn có thể mở khóa các khả năng mới.

Nvidia chưa thông báo giá GB200 mới hay các hệ thống chứa GB200. H100 dựa trên Hopper của Nvidia có giá từ 25.000 đến 40.000 USD mỗi đơn vị và toàn bộ hệ thống có giá lên tới 200.000 USD, theo ước tính của các nhà phân tích.

(Theo CNBC)